Through the Lens of Core Competency: Survey on Evaluation of Large Language Models

| Abstract From pre-trained language model(PLM) to large language model (LLM), the field of natural language processing (NLP) has witnessed steep performance gains and wide practical uses. The evaluation of a research field guides its direction of improvement. However, LLMs are extremely hard to thoroughly evaluate for two reasons. First of all, traditional NLP tasks become inadequate due to the excellent performance of LLM. Secondly, existing evaluation tasks are difficult to keep up with the wide range of applications in real-world scenarios. To tackle these problems, existing works proposed various benchmarks to better evaluate LLMs. To clarify the numerous evaluation tasks in both academia and industry, we investigate multiple papers concerning LLM evaluations. We summarize 4 core competencies of LLM, including reasoning, kowledge, reliability, and safety. For every competency, we introduce its definition, corresponding benchmarks, and metrics. Under this comepetency architecture, similar tasks are combined to reflect corresponding ability, while new tasks can also be easily added into the system. Finally, we give our suggestions on the futre direction of LLM's evaluation. |

1. 서론

● 현재까지 진행된 LLM에 대한 evaluation은 크게 세 가지로 이루어지고있음

1) dialogue, summarization 등 기존 NLP 태스크로 LLM 평가

- 실제로 LLM은 파라미터 개수와 크기만 커진 PLM에서 출발하였기에 GLUE, SuperGLUE 등의 기존 벤치마크를 사용하는 것도 무리는 아님

- 그러나 LLM이 translation, summarization, NLU task들을 제약없이, 사람보다 더 '정말 잘 수행'하는 점에서 문제 발생

2) LLM을 평가하기 위한 심화 능력(advanced bility) evaluation 개발

- LLM과 PLM는 파라미터 차이로 인해 매우 현격한 성능 차이를 보임

- 즉 scaled model들은 small-scaled model들이 가지지 못한 능력을 가지고 있을 확률이 존재

예) 모델 파라미터 수와 task effect는 선형 관계가 아니며, 매우 급격하게 증가 = "advanced"

- 이는 거대 모델들이 인간의 능력과 가깝다는 것을 의미

3) 언어 모델의 내재된 능력(intrinsic ability)에 대해 특정 태스크와 독립적으로 평가

- 위에 소개된 거의 모든 태스크들을 사용하여 병렬적으로(parallel) 평가 가능

- 여기서는 'Robustness'가 주요 평가 지표이며, 신경망의 'black-box'적인 특성과도 연결

● 최근의 평가 벤치마크(evaluation benchmark)들은 위 세 패러다임을 모두 섞은 결과

- 주로 완벽한 evaluation task 세스템 강조: 태스크별로 동등한 중요성

- 그러나 모델이 태스크에 대해 보이는 높은 성능은 여전히 논쟁거리

- 또한 수많은 태스크와 벤치마크들은 진화하는 LLM에 따라 제시되어 왔지만, 역설적이게도 systemic하게 리뷰된 바는 없음

⇒ 즉, 수많은 태스크들과 벤치마크들, 높은 성능, LLM 연구 등등을 어떻게 엮을 지는 매우 시급한 문제

● 이상적인 LLM은 capable, reliable, safe 해야하며 이런 기준을 충족하고 있는지를 살펴보아야 함

- 이에 더하여 주요(prevalent) 훈련 데이터에 대한 치팅(leakage)을 막기 위해, 테스트 셋은 주기적으로 업데이트 되어야 함

- 이는 competency tests(Hoffmann, 1999)과 비슷: 요구되는 competency와 테스트를 짝지으며, 테스트는 주기적으로 업데이트

● 본 연구는 LLM evaluation 연구에 대한 서베이 논문이며, 이들 연구에서부터 핵심 역량(core competency)을 이끌어냄

이를 위해 약 540여개의 태스크를 살펴보았으며, 역량에 따라 구분

- 4개의 핵심 역량으로 요약되며, 각 역량에 대한 정의, taxonomy, metrics를 정리

1) knowledge 2) reasoning 3) reliability 4) saftey

2. Core Competencies

2.1. Knowledge

● 지식은 보편적으로 '세계를 접할 때 인간이 인지하는 것', '시간이 지남에 따라 검증되고 재사용할 수 있는 것'으로 정의

● LLM은 매우 큰 규모의 학습 데이터를 통해 인간의 지식을 습득하며, 이를 사용하여 여러 다운스트림 태스크를 수행

● 본 장에서는 fundamental knowledge competency를 중심으로 다루며, communication과 다른 다운 스트림 태스크(주로 reasoning)를 촉진하는 역할로 간주

- fundamental knowledge는 1) linguistic knowledge와 2) world knowledge로 구분

2.1.1. Linguistics knowledge

● grammatical, semantic, pragmatic knowledge(Fromkin et al., 2018)을 포함

- 자연어의 grammar는 화자 혹은 글쓴이의 절(clauses), 구(phrases), 단어(words)에 대한 구조적 제약들을 뜻함

- 또한 음운론, 형태론, 통사론 등의 영역을 포함하며, 음성학, 의미론, 화용론 등이 보충적으로 포함

* 의미론(Austin, 1975): 단어, 구, 문장 등에 대한 의미, 특히 보편적인 의미(general meanings)를 다루는 학문

* 화용론(Austin, 1975): 언어 사용(language use)과 더불어 청자가 어떻게 화자의 의도와 문장의 의미 차이를 메꾸는지를 다룸, 이때 의미, 맥락 사용, 화자 의도 등이 고려됨

● Linguistic Knowledge competency: 모든 NLP 태스크에 내재

- 기존 연구들에서는 LLM의 linguisitc competency 테스트를 위해 특별한 시나리오들이 디자인됨

● 관련 데이터셋

- BLiMP(Warsstadt et al., 2020): 주요 문법 현상 평가

- linguistic mappings: word prediction으로 학습된 모델들에 대한 linguistic knowledge 평가

- munute mysteries qa: identify the perpetrator

- metaphor boolean: 은유인지 찾은 후 그에 대해 제대로 설명

- BIG-Bench(Srivastava et al., 2022)에는 세 개 모두 수록

2.1.2 Word knowledge Competency

● non-linguistic information: 독자 혹은 청자가 단어, 문장의 의미를 해석하는 것을 도움

● extra-linguistic knowledge 포함

1) general knowledge

- common sense knowledge(Davis, 2014): 세상에 존재하는 사실들에 관한 것, 대부분의 사람들이 알 것이라고 간주되는 것, prevalent knowledge

2) domain knowledge: 특정 학문이나 분야의 지식으로, 전문가들이 알고있을 법한 지식

- world knowledge를 평가하는 벤치마크로는 LexGLUE, WikiFact, TruthfulQA, HellaSwag 등이 있음

● 관련 데이터셋

- LexGLUE(Chaklidis et al., 2022): legal domain

- WikiFact(Tasunaga et al.,2022): fact completion scenario based on Wikipedia

- TruthfulQA(Lin et al.., 2022b): 매우 많은 분야를 다룸, 인간조차도 잘못 답변할 수 있는 문제에 대해 모델이 정확하고 사실에 기반한 답변을 하는지 평가

- HellaSwag(Zellers et al., 2019): commonsense inference and adversarial filterings to wrong answers.

2.2 Resoning

● Resoning Competency: LLM의 핵심 스킬이며 AGI(Bubeeck et al., 2023; Qiao et al., 2022)이 되기 위한 조건

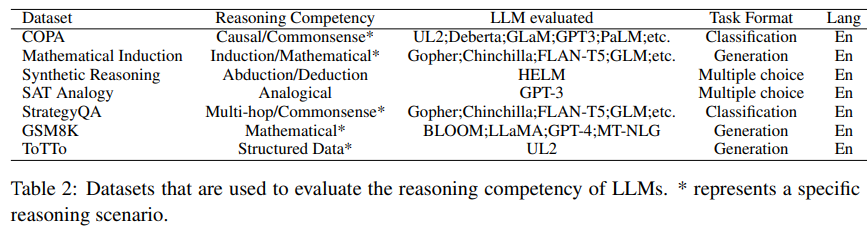

● 본 연구에서는 6개의 하위 reasoning competency로 나누어 분석

2.2.1. Causal Reasoning Competency (인과관계)

● 매우 높은 차원의 중요한 인지적 능력(highly significant cognitive ability)

- 원인-결과 간의 관계를 관찰하고 인과관계를 추론하는 능력(Vowels et al.,2023, Duendar-Coecke, 2022; Chan et al., 2023)

- events, variables, actions 간의 관계를 이해하고예측과 decision을 만들 수 있게 함 (Gao et al., 2023)

● 관련 데이터셋

- Causal-TimeBank(Mirza et al., 2014), StoryLine(Caselli and Vossen, 2017), MAVEN-ERE(Wang et al., 2022c): 두 개의 사건 혹은 문장 간 causal relationship을 평가

- COPA(Gordon et al., 2012), XCOPA(Pontiet al., 20220: 문장 안에서 causal relationships을 추출, 전제(premise)와 가능한 원인 혹은 결과로 구성

- e-CARE(Du et al., 2022), CALM-Bench(Dalal et al., 2023): causal querying tasks를 다룸, cause와 여러 개의 가능한 effect sentence로 구성

2.2.2 Deduction Reasoning Competency (연역 추리)

● logical reasoning을 위한 기초 reasoning (Evans, 2002)

● 기존의 rule-based deductive reasoning 시스템과 달리, specific conclusion 혹은 보편적으로 적용 가능한 전제로부터 규칙이나 논리를 사용해 정답을 끌어낼 수 있음

● Zero-Shot Chain-of-Thought 과 연관(Lyn et al., 2023; Kojima et al., 2022)

- 'Let's think step by step'을 사용할 경우 deduction reasoning competenct를 더 잘 평가할 수 있음 (Kojima et al., 2022)

- 대부분의 QA 태스크들은 CoT를 통해 deduction reasoning을 평가할 수 있음

- 즉, 모델의 deduction reasoning competency는 CoT를 QA에 적용한 결과를 통해 평가 가능

2.2.3 Induction Resoning Competency (귀납 추리)

● deductive reasoning과 다르게 보편적인 원칙에 대한 특정 관찰을 통해 결론을 이끌어내는 방법(Yang et al., 2022; Olsson eet al., 2022)

● general-purpose 프로그램 코드를 만드는 것에 적용 가능

- DEER(Yang et al., 2022), BIG-Bench의 Mathematical Induction(Srivastava et al., 2022)로 평가 가능

● GPT-4에 대한 Inductive competency 측정(Bills et al., 2023): 인간이 이해하기 어려운 패턴을 보임

● 추후 더 systematic하고 comprehensive한 벤치마크 개발 필요

2.2.4 Abduction Resoning Competency (귀추법)

● 주어진 input으로 생성된 output에 대한 explanation을 생성하는 데 필요한 역량(Kakas and Michael, 2020)

● 불확실하거나 충분하지 않은 정보가 주어진 상황에서 시스템이 가설을 생성할 수 있게 하고 사용 가능한 evidence들을 통해 informed decision을 만드는 시나리오와 관련

● 관련 데이터셋

- LIREx(Zhao and Vydiswaran, 2021), STaR(Zelikman et al., 2022): Abduction Reasoning process에 대한 근거들(rationales)의 effectiveness로 측정

- HUMMINGVIRRD(Mathew et al., 2021), HateXplain(Hayati et al., 2021): 감성분석 결과에 대한 reasoning

2.2.5 Analogical Reasoning Competency (유추추론)

● 다양한 상황이나 도메인 사이에서 이들을 구별하고 유사도를 구하는 능력.

- 이는 비슷한 사례 등이 공통의 특성이나 행동양상을 보이는 것에 기반

● Analogical Reasoning는 시스템에게 하나의 문맥에서 다른 문맥에 대해 transfer kowledge나 experiency에 대한 전이가 이루어짐(Sinha et al., 2019;Wei et al., 2022b)

- 이러한 태스크는 과거의 경험으로부터 배우거나 문제 해결(Problem Solivning), 결정 선택(decision making)에 필요

● 관련 데이터셋

- Brown et al.(2020)은 SAT Analogie: LLM모델의 analogical reasoning 능력을 측정하고 이해하기 위해 구축

- 저자 판단과 ARC dataset(Srivastava et al., 2022)역시 자주 사용

● 다만 In-Context Learning(ICL)이 거의 모든 태스크에서 사용될 수 있기에, 이 Analogical Reasoning Competencyt는 ICL을 통해 측정 가능

2.2.6 Multi-hop Reasoning Competency

● 다양한 출처 혹은 맥락으로부터 오는 정보들을 묶고 통합하거나 논리적으로 결론에 이르는 능력

● 이를 통해 시스템은 여러 정보를 탐색하여 일관성(coherence) 있고 포괄적인(comprehensive) 답변 리턴 가능

- 정보 검색, 이해 및 추론 태스크 수행에 기초가 됨(Wang et al., 2022a; Qiu et al., 2019)

● 관련 데이터셋

- HotpotQA(Yang et al., 2018): 멀티홉 질의응답 데이터셋

- StrategyQA(Geva et al., 2021): HotpotQA와 더불어 널리 쓰이는 데이터셋

reasoning step이 질문에 내포(implicit)되어 있으며, 전략(strategy)들을 통해 이끌어내야 함

2.2.7 Reasoning in Scenerios

1) Commonsense Reasoning

- 기계들이 사람과 같은 이해, 세계와의 적극적인 상호작용을 위해 꼭 필요한 reasoning(Storks et al., 2019;Bhargava and Ng, 2022)

- 정확한 예측, 논리적 reasoning, 복잡한 사회적 상황에 대한 이해 등을 가능하게 함

- OpenBookQA(Mihaylov et al., 2018), CommonsenseQA(Talmor et al., 2019): rich world knowledge 필요

- PIQA(Bisk et al., 2020): 물리적인 세계 내 commonsense에 대한 reasoning을 다룸

- CommonsenseQA의 경우 LLM에 대한 벤치마크로 자주 활용

2) Mathematical Reasoning

- 매우 중요한 역량 중에 하나

- 인공지능으로 하여금 logical reasoning, problem-solving, data 조작과 분석에 반드시 필요

- 초기에는 초등학교 수준의 수학 문제에서 시작(MWPs; Hosseini et al., 2014)

- 현재는 복잡도와 스케일이 많이 증가한 상태

- external knowledge 등을 동원하는 multilingual, multi-modal로의 확장이 이루어지고 있음(Lindstrom and Abraham, 2022;Shi et al., 2023)

3) Structured Data Reasoning

- 정형 데이터(structured data)를 다루며, 대표적인 예로는 표가 있음

- WikiSQL(Zhong et al., 2017), WikiTA(Pasupat and Liang, 2015): 표를 대상으로 하는 QA

- HybridQA(Chen et al., 2020b), MultiModalQA(Talmor et al., 2021): 텍스트와 표를 섞은 형태의 QA

- ToTTO(Parkh et al., 2020): 오픈 도메인 표-텍스트 데이터셋

- TabFact(Chen et al., 2020a), FEVEROUS(Aly et al., 2021): 구조화된 데이터와 모델의 결과가 일치하는지를 평가

- 수학적 reasoning과 표를 섞은 TabMWP(Lu et al., 2023)도 존재

2.3 Reliability

● LLM이 생성한 내용이 믿을 만한 지를 측정: LLM이 매우 빠른 속도로 발전함에 따라 필수 지표가 됨(Weidinger et al., 2021; Wang et al., 2022d; Ji et al., 2023; Zhuo et al., 2023).

● hallucination, truthfulness, factuality, honesty, calibration, robustness, interpretability 등을 포함하나, 꼭 국한되지 않음

● Reliability는 또 safety와 LLM의 generalization과 겹치기도 함

- 본 연구에서는 Hallucination, Uncertainty, Calibration을 Realiability의 부분으로 연구

2.3.1 Hallucination

● LLM의 거짓말(falsehood)을 뜻하는 용어로, truthfulness, factuality의 반대

● 크게 intrinsic hallucination과 extrinsic (open domain) hallucination으로 나뉨

1) intrinsic hallucination: 주어진 문맥에 대해 모델의 출력이 unfaithfulness한 정도

2) extrinsic hallucination: 주어진 문맥 없이 모델이 세계(world)에 대해 출력한 내용의 unfaithfulness 정도

- 초기 연구는 주로 intrinsic hallutination에 초점, 그러나 현재는 extrinsic hallutination 연구가 활발

● extrinsic hallutination 평가 시 지식 집약적인(knowledge-intensive) 태스크들이 많이 쓰임

- 주로 다지선다(multiple-choice)나 사실인지 아닌지 분류하는 태스크로 구성

● 관련 데이터셋

- Factual Question Answering (Joshi et al., 2017; Zheng et al., 2023), Knowledge-grounded Dialogue (Dinan et al., 2019b; Das et al., 2022).,

- TruthfulQA (Lin et al., 2022b): 가장 널리 쓰이는 데이터셋, 817개 질문, 38개 카테고리로 구성

2.3.2. Uncertainty and Calibration

● 신뢰성 있는 언어 모델들은 출력에 대해 confidence 정도를 조절할 수 있는 능력이 있어야 함

● 즉, 불확실성(uncertainty)를 유의하는지 보아야 함

- 모델이 스스로의 불확실성을 측정하는 정도: self-aware, honesty, known-unknown 등으로 불러왔음

● Calibration: application 차원에서의 classifier에 대한 불확실성

- well-calibrated된 classifier는 현실에서 경험론적인 정확도와 부합하는 확률을 리턴함

● 주로 다지선다, 분류에 대해 측정

- HELM(Liang et al., 2022): calibration을 하나의 metric으로 설정하여 다지선다, 분류 태스크에 적용

- GPT-4 역시 RLHF 전 다지선다 태스크에 대해 학습된 결과가 매우 well-calibrated됨을 보인 바 있음(OpenAI, 2023)

● 다만 free-form generation의 경우, 다지선다나 분류와는 다른 양상을 보임

- 언어의 semantic nature과 예측할 수 없는 출력 가능성 등에 의해 특이한 양상

- Kuhn et al. (2023): 모델 출력을 클러스터링하여 모델의 불확실성을 측정하는 알고리즘 개발

- Mielke et al. (2022): 모델을 항상 부정확한 정답에 대해 confidence를 가짐, 'linguistic calibration' 개념을 도입하여 모델에 동사구에 대한 불확실성을 학습

- Lin et al.(2022a): 자연어 안의 불확실성 확률을 예측할 수 있도록 모델 학습

- SelfAware dataset (Yin et al., 2023): 대답할 수 없는 질문을 통해 모델의 불확실성을 측정

2.4 Safety

● LLM이 삶 속에 깊숙하게 들어옴에 따라 safety에 대한 필요성 증가

- LLM은 본래 통계 기반 모델이므로 내부적으로 한계나 잠재된 위협이 충분히 있을 수 있음

- 단, LLM의 safety를 측정하고자 하는 데이터셋들이 구축되어 있으나, 타당성(validity)이나 safety 판단에 대한 당위성(authority) 등 재고가 필요

- 또한 'safety'에 대한 정의 역시 아직까지는 주관적

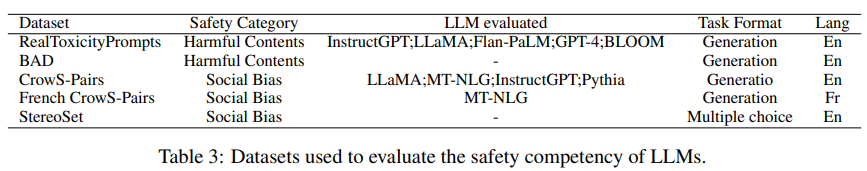

● 본 연구에서는 harmfulness와 unfairness & social bias 를 중심으로 고찰

2.4.1 Harmfulness

● harmful contents: offensive language나 특정 대상에 대해 표면적으로 위협이 드러나는 경우

- 그러나 합의된 정의는 아니며, 서베이 결과 5개 측면(offensiveness, violence, crime, sexual-explicit, unauthorized expertise) 을 발견

● 대부분의 연구는 LLM 출력의 harmfulness를 측정 (Wulczyn et al., 2017; Davidson et al., 2017; Zampieri et al., 2019; Dinan et al., 2019a)

● 다른 연구들의 경우 LLM이 안전한 답변을 생성하는데 초점을 둠(Krause et al., 2021; Atwell et al., 2022)

● 한편 심리학적 동기나 의료적 측면의 모델의 경우 비전문성을 허용하지 않아야 함 (Sun et al., 2022)

● 관련 데이터셋

- RealToxicityPrompts (Gehman et al., 2020): 100,000개 프롬프트로, toxicity 분류에 사용

- BAD(Xu et al., 2021): 사람이 선택한 위협이 되는 출력으로 구성, 5,000개 대화로 구성되어 있음

2.4.2 Unfairness and Social Bias

● social bias: LLM에 내재된 특징이며 인구학적으로 다른 집단의 언어 분포가 반영되었기 때문에 발생

● unfairness: 보다 외재적(external)인 형태로, 특정 태스크에 대한 수행 결과에 반영되어 있음

예) African American English(AAE): offensive language로 자주 분류되는 경향 (Lwowski et al., 2022)

● 하지만 social bias와 unfairness는 인간 언어에 이미 널리 분포되어 있기에 불가피한 측면

● 관련 데이터셋

- CrowS-Pairs(Nangia et al., 2020): social bias 벤치마크 데이터셋으로, gender, race, nationality 등 social bias를 포함한 문장 1508개로 구성

- StereoSet(Nadeem et al., 2021): 단어/문장 층위에서의 social bias 측정이 가능한 데이터셋

2.4.3 기타

● safety와 관련해서는 아직까지 뚜렷한 golden standard가 없는 상태

- LLM을 morality, ethics와 더불어 다양한 society와도 align하는 것이 중요

● 향후 privacy 및 political 위협(risk)에 대한 연구 필요

- LLM 학습 시 다양한 장르, 출처 등을 가진 데이터가 활용되므로, 프라이버시 문제가 잠재될 위험성 존재

예) 신체적 정보, 집주소 등 민감 정보 포함

- 현재까지 LLM들은 privacy에 매우 취약, 공격에 민감 정보를 노출할 가능성이 큼(Carlini et al., 2020; Li et al., 2022)

● political issue의 경우에도 학습 데이터에 잠재. 해당 문제는 국가, 사회적 집단, 정치적 입장 등과 밀접한 관계

3. 향후 연구 방향

3.1. 감성(Sentiment)

● LLM에 반드시 포함되어야 할 역량에는 sentiment에 대한 이해 및 생성이 있음

1) 이해: 의견, 감성, 감정 등을 이해하는 것과 연관

예) sentiment classification, aspect-based sentiment analysis 등

- 기본적으로 퓨샷 러닝으로 감성 이해에 대한 성능을 높일 수 있으며,

- LLM의 감성 이해 평가는 다중 도메인 데이터셋 혹은 comprehensive한 벤치마크 등으로 수행하여야 함

2) 생성: 2가지 측면으로 분류 가능

(1) 감성을 포함한 문장 생성:

(2) 감성을 끌어내는(elicit) 문장 생성: common sense 이해 역량 필요

● 오픈 도메인 감정 대화 이해, 공감 대화(empathic dialoguge) 등의 시나리오 사용 가능

● 단, 아직까지 LLM의 감정 생성에 대해 연구가 활발하게 진행되지는 않고 있음

3.2 Planning

● 실제 활동(action) 혹은 목표 달성을 위해 이전에 계획되어야 하는 내용에 대한 조직 능력

● LLM의 planning 역량을 다룬 연구들이 소수 존재: 주로 common sense나 LLM의 계획 능력 평가에 초점

예) 결혼식 계획 세우기, LLM의 목표 달성까지의 수행 결과 평가 등...

3.3 코드

● 코드의 경우 LLM의 성능 증명 뿐만 아니라 LLM 스스로가 진화(self-evolving)할 수 있는 가능성까지 잠재

● 코드 생성과 이해 모두를 포함

- HUMANEVAL(Chen et al., 2021): 164쌍의 인간 작성 docstring과 유닛 테스트 결과

● 그러나 여전히 LLM의 코드 능력을 측정하는 벤치마크들이 더 개발되어야 함

4. 결론

● LLM 평가에 대한 서베이 논문

● reasoning, knowledge 등은 이미 총체적(holistic)인 벤치마크를 가지고 있음

● planning, code 등은 여전히 평가할 수 있는 방법이 부족함

● 벤치마크로 평가되어야 하는 역량 등을 정리하고 LLM 평가에 대해 방향을 제시했다는 점에서 의의